第250115期 - tabby

第250115期 - tabby

25.4k star,自部署的AI编程助手,堪称效率神器

这个项目之前就看到过,一直以为是那款终端工具tabby,今天看到这个项目又在趋势榜第一,点进去一看,是我浅薄了。

Tabby 是一个自托管的 AI 编码助手,提供了一个开源且本地部署的替代方案,旨在与 GitHub Copilot 竞争。Tabby 的设计初衷是为开发者提供一个无需依赖外部数据库管理系统或云服务的解决方案。它的开放 API 接口使其易于与现有基础设施集成,例如云端 IDE。此外,Tabby 还支持消费级 GPU,使其在硬件要求上更加亲民。

Tabby 的特点主要体现在以下几个方面:

- 自包含性:Tabby 不需要外部数据库管理系统或云服务,所有数据都可以本地存储和处理。这意味着用户可以完全控制自己的数据,确保隐私和安全。

- 开放 API 接口:Tabby 提供了一个开放的 API 接口,使其可以轻松地与现有的开发工具和基础设施集成。例如,用户可以将 Tabby 集成到他们的云端 IDE 中,提升开发效率。

- 支持消费级 GPU:Tabby 支持消费级 GPU,这意味着用户不需要昂贵的硬件设备就可以运行 Tabby。这使得 Tabby 成为一个经济实惠的选择,适合个人开发者和小型团队使用。

快速开始使用 Tabby 非常简单。以下是一些基本步骤:

-

安装 Docker:首先,你需要在你的系统上安装 Docker。Docker 是一个开源的容器化平台,可以帮助你轻松地部署和管理应用程序。

-

运行 Tabby 服务器:安装 Docker 后,你可以使用以下命令来启动 Tabby 服务器:

docker run -it \ --gpus all -p 8080:8080 -v $HOME/.tabby:/data \ tabbyml/tabby \ serve --model StarCoder-1B --device cuda --chat-model Qwen2-1.5B-Instruct这个命令将启动 Tabby 服务器,并将其绑定到本地的 8080 端口。你可以根据需要修改命令中的参数,例如模型类型和设备类型。

-

配置 Tabby:启动 Tabby 服务器后,你可以通过访问本地的 8080 端口来配置 Tabby。Tabby 提供了一个简单易用的配置界面,你可以在这里设置各种参数,例如并行度和推理类型。

-

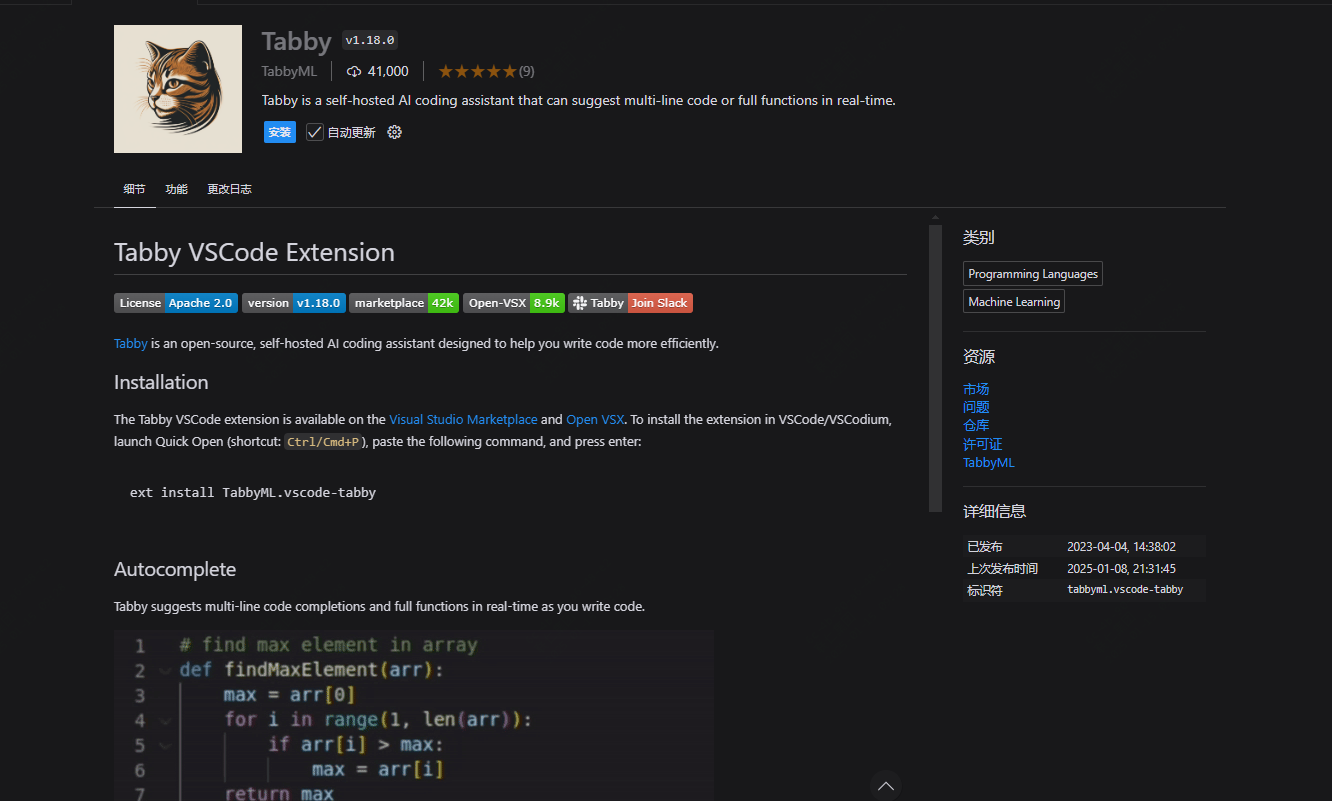

集成到 IDE:Tabby 提供了多种 IDE 和编辑器扩展,你可以根据自己的开发环境选择合适的扩展。例如,如果你使用的是 VS Code,你可以安装 Tabby 的 VS Code 扩展,并在设置中配置 Tabby 服务器的地址。

-

开始使用:配置完成后,你就可以开始使用 Tabby 了。Tabby 提供了多种功能,例如代码补全、代码生成和代码优化,可以帮助你提升开发效率。

总的来说,Tabby 是一个功能强大且易于使用的 AI 编码助手,适合各种开发者使用。无论你是个人开发者还是团队的一员,Tabby 都可以帮助你提升开发效率,简化编码过程。通过简单的安装和配置,你就可以快速开始使用 Tabby,享受 AI 带来的便利和高效。

网址:github.com/TabbyML/tabby